Caricamento player

Realizzare video utilizzando software di intelligenza artificiale è diventata un’operazione accessibile a chiunque: basta abbonarsi a una delle tante piattaforme text-to-video (come Sora di ChatGPT, Veo di Google o Runway), spesso a prezzi piuttosto contenuti, per trasformare una semplice descrizione testuale – detta prompt – in un filmato completo, con tanto di ambientazioni generate artificialmente e dialoghi recitati da voci sintetiche sincronizzate con i personaggi sullo schermo.

Finora le preoccupazioni relative a questi software hanno riguardato soprattutto la veridicità dei contenuti, perché alcuni video generati dall’intelligenza artificiale possono risultare così realistici da trarre in inganno chi ha poca dimestichezza con queste tecnologie o non è abituato a riconoscerne i difetti distintivi (tipo le imperfezioni nelle mani). Ultimamente sono emerse nuove preoccupazioni legate a un utilizzo diverso di questi software, che non vengono più impiegati soltanto per la creazione di video falsi, ma anche per manipolare e ritoccare contenuti originariamente autentici.

Se ne sta parlando in questi giorni per due motivi principali. Uno è una polemica nata attorno ad alcuni video promozionali condivisi dall’attore e rapper Will Smith, che sembravano voler spacciare per vera una folla che non aveva partecipato ai suoi concerti – la folla invece c’era davvero, ma era stata animata digitalmente. Il secondo motivo riguarda invece YouTube, che da qualche settimana ha introdotto un filtro che utilizza l’intelligenza artificiale per migliorare alcuni dettagli dei video caricati sulla piattaforma o ottenere ombre più definite, contorni più netti e una chiarezza dell’immagine amplificata.

La nuova funzionalità è stata introdotta senza avvisare preventivamente i creatori di contenuti, che hanno cominciato a lamentarsi delle modifiche che l’intelligenza artificiale apporta automaticamente ai loro video. Non è chiaro se i filmati modificati vengano mostrati a tutti gli utenti o solo a una parte, dato che spesso YouTube testa nuove funzioni su gruppi limitati di persone.

Il giornalista dell’Atlantic Alex Reisner ha chiesto chiarimenti a Allison Toh, portavoce di YouTube, che ha spiegato che YouTube non sta usando software di intelligenza artificiale generativa, ma sistemi di machine learning tradizionali che prendono un video già pronto e applicano correzioni mirate, come togliere sfocature o aumentare la nitidezza. In questo caso il software lavora su quello che c’è già, migliorandolo con piccoli ritocchi automatici.

Secondo Reisner, però, la descrizione di Toh ricorda molto da vicino il funzionamento dell’intelligenza artificiale generativa, che non si limita a ritoccare ma produce di fatto una nuova versione del contenuto. Questi sistemi, infatti, partono da immagini molto degradate e le “ricostruiscono” gradualmente fino a renderle chiare e levigate, inventando i dettagli che mancano sulla base di ciò che hanno appreso nell’addestramento. È proprio questa somiglianza nel metodo a spiegare perché i video corretti da YouTube mostrino i segni tipici dei contenuti sintetici, come contorni e ombre troppo accentuate.

Tra i creatori di contenuti che si sono lamentati delle modifiche introdotte dalla piattaforma c’è Mr. Bravo, uno youtuber statunitense che registra i suoi video con un vecchio videoregistratore per ottenere un effetto vintage. In un post pubblicato su Reddit, Mr. Bravo ha detto che, a causa delle correzioni automatiche di YouTube, ormai la resa estetica dei suoi video è «completamente diversa da com’era stata pensata originariamente».

Anche Rhett Shull, un famoso youtuber statunitense che si occupa di didattica per chitarra, ha pubblicato un video per parlare di come YouTube stia stravolgendo i suoi contenuti. «Temo che la gente possa pensare che io utilizzi l’intelligenza artificiale nei video, o che siano stati falsificati: questo eroderà inevitabilmente la fiducia degli spettatori», ha detto.

Nel caso che riguarda Will Smith, invece, il cantante statunitense accusato di aver usato l’intelligenza artificiale per un video promozionale che in realtà raccoglieva solo scene autentiche dai concerti del suo tour estivo, Based on a True Story.

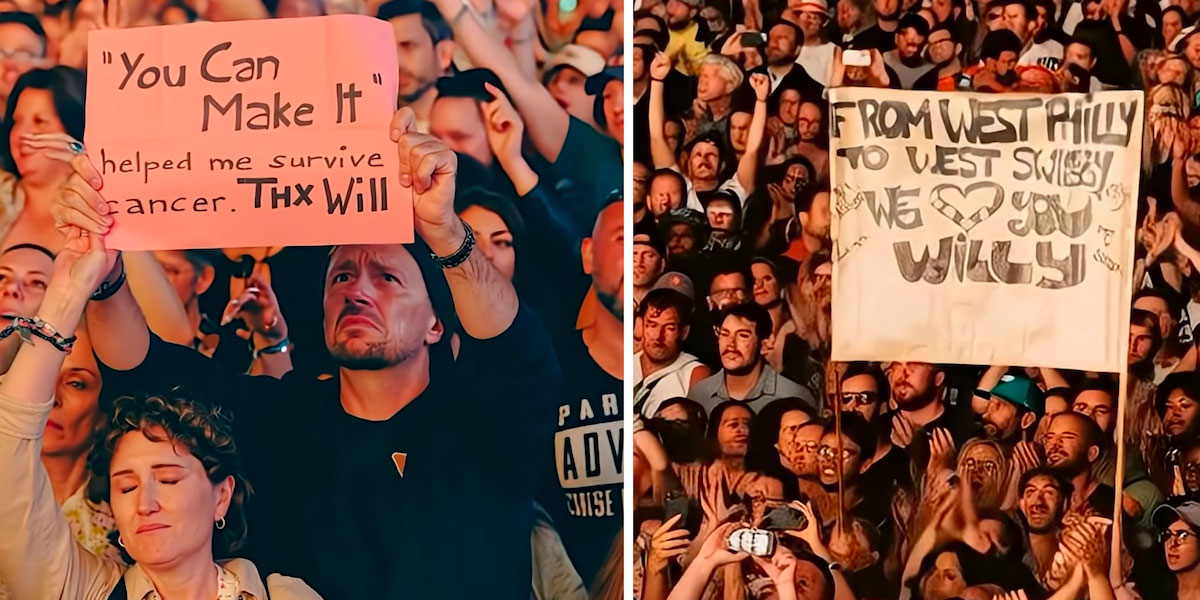

Nel video Smith canta il suo ultimo singolo “You Can Make It” davanti alle prime file del pubblico, con immagini riprese in vari festival europei. Era stato pubblicato su Instagram e YouTube lo scorso 12 agosto, e fino a qualche giorno fa non aveva generato particolari dubbi. Negli ultimi giorni però alcuni utenti hanno fatto notare dettagli che sembravano suggerire un’origine artificiale del video: volti sfocati, sorrisi troppo accentuati, mani deformate e cartelloni con scritte enfatiche che coprono intere porzioni di pubblico.

In realtà il pubblico era reale: come ha ricostruito Andy Baio, blogger esperto di tecnologia e cultura di internet, le immagini del video provengono da concerti del recente tour europeo di Smith. Baio ha messo a confronto il filmato con le gallerie fotografiche ufficiali dei festival e con i post pubblicati sull’account Instagram di Smith, che ritraggono le stesse persone e gli stessi cartelli.

Anche la scena più contestata, quella di una coppia con un cartello con la scritta «“You Can Make It” mi ha aiutato a sopravvivere al cancro», non è stata generata dall’intelligenza artificiale. La coppia aveva partecipato al concerto di Smith al Gurtenfestival di Köniz, in Svizzera, e compare anche in altre foto ufficiali dell’evento.

Come ha spiegato Baio, l’effetto “finto” del video è dovuto a due passaggi di post-produzione. Prima il team di Smith ha usato l’intelligenza artificiale per animare alcune foto reali del pubblico, provocando le prime sfocature; poi il nuovo filtro di YouTube ha peggiorato ulteriormente la resa del video, accentuandone la sensazione di artificialità.

– Leggi anche: Storie di interazioni con ChatGPT finite molto male

Un altro dibattito sul potenziale raggiunto dai software di intelligenza artificiale si era sviluppato a fine luglio, quando un video di coniglietti pubblicato su TikTok e visto da quasi 200 milioni di persone era riuscito a ingannare anche gli utenti più giovani, i più scafati e abituati a riconoscere i video prodotti con strumenti di questo tipo, che in moltissimi casi lo avevano preso per vero. Era stato un momento di consapevolezza collettiva sul fatto che anche chi si ritiene più al sicuro dalle frodi dell’intelligenza artificiale può cascarci.

Il video mostra un gruppo di coniglietti che saltava su un trampolino, ed era sembrato particolarmente realistico perché la ripresa aveva l’effetto oscuro e sfocato tipico delle telecamere di sorveglianza di notte.

L’origine artificiale del video è stata scoperta dal sito specializzato 404media, che ha notato come, tra il quinto e il sesto secondo del filmato, uno dei coniglietti sparisce dall’inquadratura. Simulare la filigrana dell’immagine notturna di una telecamera di sicurezza è in effetti un modo piuttosto efficace per nascondere alcuni dei difetti più noti dei video prodotti dall’intelligenza artificiale, come movimenti innaturali, luci troppo intense e dettagli poco realistici.

– Leggi anche: Come si riconosce un video fatto con l’intelligenza artificiale